Las Vegas, Nevada.- Ante el continuo crecimiento en la complejidad de modelos de Inteligencia Artificial (IA) y Machine Learning (ML), así como su integración en procesos empresariales de múltiples verticales, Adam Selipsky, CEO de Amazon Web Services (AWS), destacó la importancia de construir la mejor infraestructura que permita atender la demanda de procesamiento de cómputo a un costo efectivo, por lo que la compañía anunció mejoras a sus líneas de semiconductores y plataformas de desarrollo.

Semiconductores más eficientes en costo y energía

Durante su presentación en el AWS Re:Invent 2023, Selipsky anunció la nueva generación del chip Graviton4, enfocada en procesamiento de cómputo general, que ofrece hasta 30 por ciento mejor rendimiento, con un 50 por ciento más de núcleos y un 75 por ciento más de ancho de banda respecto a la versión anterior.

Según el directivo, actualmente están disponibles más de 150 instancias impulsadas por Graviton en AWS, a las que acceden más de 150 mil clientes, entre los que se encuentran compañías como SAP, que ha registrado un rendimiento 35 por ciento superior, con una reducción del 45 por ciento en el impacto de carbono.

Selipsky resaltó que para impulsar las nuevas cargas de trabajo de IA, la compañía se ha enfocado en invertir en el desarrollo del ecosistema, desde la infraestructura base como semiconductores, pasando por herramientas para el desarrollo y entrenamiento de modelos fundacionales, hasta las aplicaciones que aprovechen estos modelos.

En ese sentido, para atender las cargas de trabajo especializadas en IA y ML, AWS presentó también la nueva iteración de su chip Trainium2, diseñado para ofrecer un entrenamiento hasta cuatro veces más rápido, con la opción a ser desplegado en instancias EC2 UltraClusters de hasta 100 mil chips, lo que permite entrenar modelos fundacionales (FM) y Grandes modelos de lenguaje (LLM) en una fracción del tiempo con una eficiencia energética del doble.

Chip Trainium2, enfocado en cargas de trabajo para entrenamiento de modelos de IA

Los nuevos chips podrán ser aprovechados por AWS Neuron, el SDK de la compañía para aceleración de Deep Learning, que ahora trabaja con 93 de los 100 modelos LLM más populares, además de modelos open source de hugging face. En conjunto con Sagemaker, AWS dará soporte para entrenar modelos de hasta 180 mil millones de parámetros.

AWS y Nvidia introducen supercomputadoras para IA

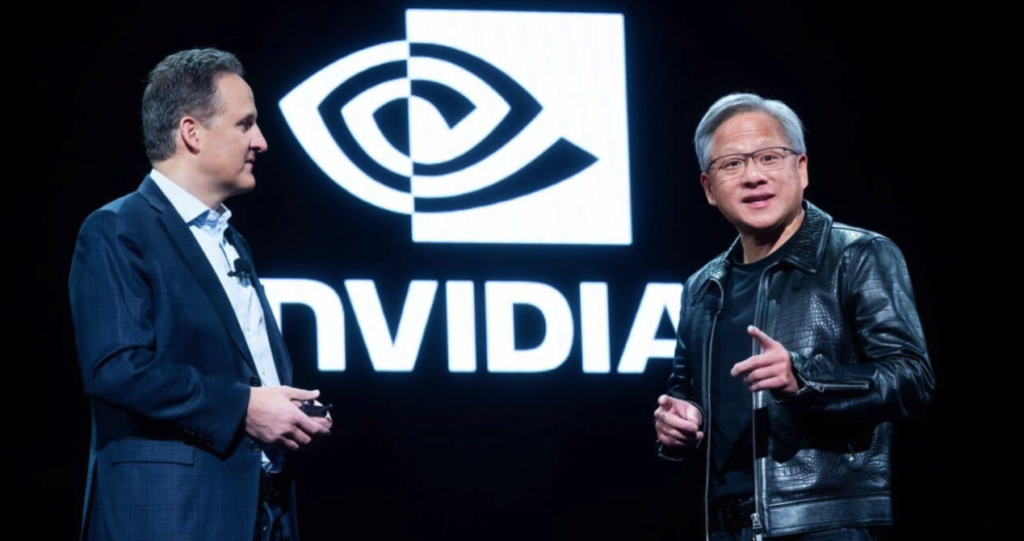

En el evento estuvo presente Jensen Huang, CEO de Nvidia, para anunciar una colaboración más estrecha con AWS que incluye la primera supercomputadora de IA en la Nube impulsada por el superchip GH200 Grace Hopper y enlaces NVLink, que permite la conectividad de hasta 32 superchips y servidores de clúster de alto rendimiento.

Hasta ahora, la colaboración de AWS y Nvidia ha implicado el despliegue de más de 2 millones de GPUs, que representan 3 mil supercomputadoras a exaescala. La colaboración entre ambas empresas ha permitido la adición de capacidad cómputo a un ritmo de 1 Teraflops por trimestre.

El nuevo anuncio de colaboración en Las Vegas incluyó la introducción de nuevas instancias impulsadas por las GPU NVIDIA GH200, H200, L40S y L4 supercargadas para las cargas de trabajo de IA Generativa, HPC, diseño y simulación. La integración incluye conectividad Nvlink que permite conectar hasta 32 GH200, con soporte para virtualización avanzada con AWS Nitro.

Ambas compañías colaborarán también para alojar NVIDIA DGX Cloud, entrenamiento de IA como servicio de NVIDIA, siendo AWS la primer Nube DGX con GH200 NVL32, que proporcionará a los desarrolladores la mayor memoria compartida en una sola instancia.

También lee: Gasto de TI en América Latina crecerá 5% en 2024 pese a efectos macroeconómicos

DGX Cloud en AWS acelerará la formación de IA Generativa y grandes modelos de lenguaje que pueden alcanzar más de un billón de parámetros para múltiples casos de uso como robótica, coches autónomos o hasta gemelos digitales, como una simulación de la Tierra que permite mejorar pronósticos del clima.

AWS y Nvidia también colaborarán en Proyecto Ceiba, una supercomputadora impulsada por 16 mil 384 Superchips NVIDIA GH200, con capacidad para procesar 65 exaflops de IA.

Herramientas para entrenamiento de modelos

Además de la infraestructura, Selipsky destacó la importancia de ofrecer nuevas herramientas para mejorar entrenar y construir modelos IA a escala, como Bedrock.

Selipsky presentó la actualización de los modelos Amazon Titan, una plataforma de la compañía para para modelos base de IA de forma segura y responsable, para impulsar casos de uso de empresas de forma privada, sin comprometer su información.

Para adaptar mejor estos modelos a los requerimientos y necesidades de las empresas, AWS presentó Fine Tuning, que permitirá adaptar los modelos con datos de las operaciones, clientes y modelos de negocio particulares de las empresas. Esta solución estará disponible para modelos como Command de Cohere, Meta LLama 2, y los modelos propietarios de Amazon, Titan Text Lite y Express, con un próximo lanzamiento para Claude de Anthropic.

Esta solución estará complementada con Retrieval Augmented Generation, disponible ahora de manera general, para alimentar los modelos fundacionales con fuentes de datos propios de cada empresa; así como con Continued pre-Training, disponible como vista previa desde Amazon Bedrock, para uso de datos no etiquetados, incluyendo planes financieros o investigaciones de marketing.

Adicionalmente, se introdujo Agents para Amazon Bedrock, que permitirá crear ‘agentes’ con IA Generativa desde una interfaz con lenguaje natural, que no sólo responderán preguntas, sino permitirán ejecutar múltiples tareas, como responder dudas de clientes o hasta tomar una orden. Por ejemplo, crear un agente de seguros diseñado para procesar reclamos de seguro, y dar una respuesta basada en información y datos de la propia empresa.