Con participación de Efrén Páez

En tiempos en los que el tablero geopolítico se redefine, América Latina muestra resultados de la cooperación de sus países en la propuesta Latam-GPT, que se presentó a sí mismo como “un modelo de lenguaje grande desarrollado específicamente para América Latina, con énfasis en su cultura, idioma, historia y realidades sociales”. Protagonistas destacan el lanzamiento como un paso clave para que la región deje de ser consumidora y se convierta en protagonista de la conversación digital del futuro.

“Pasamos de ser el menú a estar en la mesa”, sintetizó el presidente chileno, Gabriel Boric, durante el lanzamiento.

El desarrollo es fruto del trabajo coordinado por el Centro Nacional de Inteligencia Artificial de Chile (Cenia) en colaboración con distintas entidades regionales. Cuenta con el apoyo de más de una decena de países, seis de los cuales ya firmaron memorandos de entendimiento interministeriales: Brasil, República Dominicana, Perú, Costa Rica, Panamá y Colombia, recientemente incorporado.

La voz de los protagonistas

“Es una gran innovación para el desarrollo de las comunicaciones, de las tecnologías de la información en nuestro país y en América Latina y el Caribe. En el contexto que tenemos hoy día, en que se ven tantas disputas, impulsar un proyecto de cooperación como este, en el que avanzamos juntos los países de este hemisferio para dotarnos de un modelo de lenguaje que releve y preserve nuestras tradiciones en el lenguaje, en nuestras singularidades idiosincráticas, es también una acción de defensa de nuestra cultura y de dignidad que tenemos y merecemos”, valoró el ministro chileno de Ciencia, Tecnología, Conocimiento e Innovación, Aldo Valle, en diálogo con DPL News.

Entre los principales desafíos de la iniciativa señaló el “enorme esfuerzo político, diplomático y de gestión que conllevó reunir información de distintos países” y generar las instancias de cooperación entre universidades, instituciones públicas y privadas.

Sobre lo que viene, dijo que “coordinaremos acciones” con los países ya firmantes para “el desarrollo de capacidades tecnológicas autónomas en Inteligencia Artificial, evitando la dependencia exclusiva de modelos extranjeros y promoviendo soluciones alineadas a la realidad latinoamericana”. También indicó que Chile avanza en “un marco regulatorio, promovido a partir de un proyecto de ley en el Congreso” para, entre otros puntos, promover esfuerzos con universidades.

¿Cómo avanzará el modelo tras el cambio de autoridades? “Estamos iniciando un traspaso ordenado, una memoria institucional relevando especialmente los informes y evaluaciones de las políticas que se han impulsado durante el gobierno de Boric. Chile tiene una Política Nacional de Inteligencia Artificial y estrategias en materia de biotecnología y de tecnologías cuánticas, estamos relevando estos informes de modo que eso contribuya a que las nuevas autoridades tengan los antecedentes necesarios para que estas tareas continúen”, respondió Valle.

Ante la consulta de DPL News, el subsecretario de Telecomunicaciones, Claudio Araya San Martín, consideró que el lanzamiento es “una señal de que no queremos ser simplemente consumidores. Al dar el salto tecnológico hacia la IA se abre una oportunidad para ser protagonistas y lo que se está buscando es eso, es generar tecnología. Tenemos talento de sobra en la región. Vemos una oportunidad para que Latinoamérica presente una alternativa en el desarrollo de estas nuevas tecnologías y de esa forma avancemos en mejoras de la calidad de vida de las personas, a través de una dinamización de la actividad económica y la soberanía tecnológica”.

Distintas entidades valoraron la noticia como un paso clave para que América Latina participe de forma activa en los desarrollos tecnológicos y se convierta en voz autorizada en debates globales relacionados con la materia.

“Muy contentos desde CAF —Banco de Desarrollo de América Latina y el Caribe— de haber sumado al proceso de Latam-GPT, un gran hito para América Latina y el Caribe. (…) No es sólo un nuevo modelo de Inteligencia Artificial. Es el primer gran modelo de lenguaje concebido, desarrollado y entrenado desde la región, con identidad propia, diseñado para comprender nuestras lenguas, contextos institucionales y diversidad cultural”, resaltó en una publicación en Linkedin Eduardo Chomali, alto Ejecutivo de Proyectos de Transformación Digital del banco regional.

Para el ejecutivo, este proyecto se trata de “un bien público regional de IA, una infraestructura común que reduce barreras de entrada, democratiza el acceso a capacidades avanzadas y potencia el talento local. Este lanzamiento es sólo el primer paso: el desafío ahora es darle escala y sostenibilidad, invirtiendo en cómputo, conectividad, datos de calidad, talento y políticas públicas consistentes. Cuando América Latina y el Caribe coopera, invierte en conocimiento y construye capacidades propias, no sólo adopta el futuro: lo diseña y lo construye”.

En sintonía, la Asociación Latinoamericana de Internet (ALAI) celebró la noticia. Puntualizó que el lanzamiento pone sobre la mesa un desafío central: para que este tipo de iniciativas tengan éxito, es imprescindible contar con marcos regulatorios y políticas públicas que acompañen la innovación y no la limiten. “Varias propuestas regulatorias tienen el riesgo de imponer restricciones que dificultarían el uso de información local para el entrenamiento de modelos, lo cual es contrario al deseo de impulsar y fortalecer este tipo de proyectos”, disparó la entidad

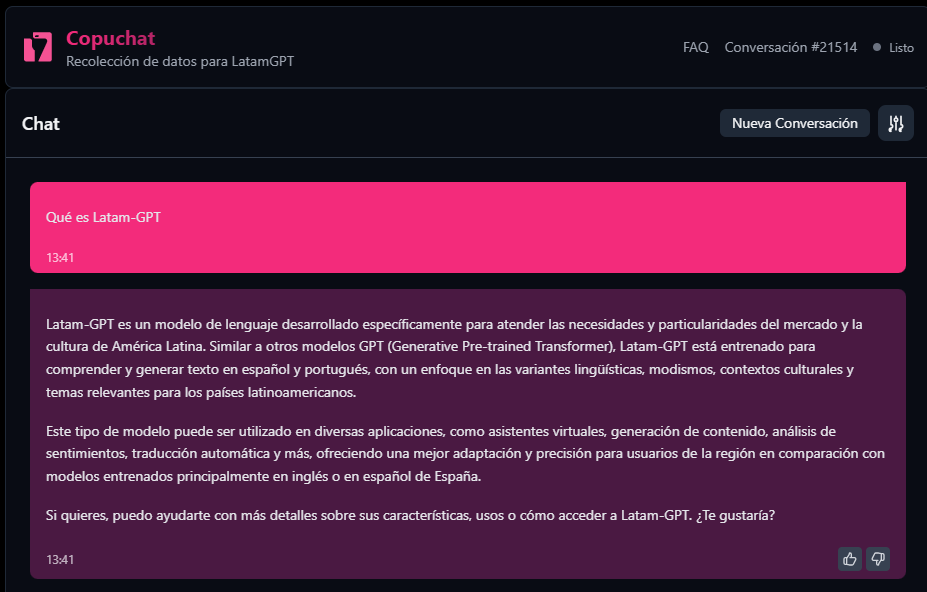

Funcionamiento: cómo y para qué

Para llegar a la creación de un modelo 1.0 de Latam-GPT, el proceso consideró la recolección y curaduría de datos, además de un periodo de pre y post training. El modelo se desarrolló sobre una arquitectura de base Llama 3.1, con 70,000 millones de parámetros, que se complementó con un corpus regional, lo que se definió como un conjunto organizado de textos y contenidos con los que se entrena un modelo de lenguaje para que este comprenda el contexto cultural e identitario de la región.

Participaron instituciones públicas, académicas y tecnológicas de la región, articulando a más de un centenar de profesionales y decenas de instituciones. En total, se reunieron más de 300,000 millones de tokens de texto plano, equivalentes a alrededor de 230,000 millones de palabras, obtenidos bajo permisos y licencias explícitas, curados de tal manera de asegurar la anonimización de datos y eliminar elementos tóxicos.

Según estimaciones previas, los datos en español y portugués representan el 4% y 2%, respectivamente, del total utilizado para entrenar sistemas de Inteligencia Artificial. “Esta subrepresentación implicó que las realidades latinoamericanas no fueran consideradas de manera adecuada ni en el diseño ni en el entrenamiento inicial de gran parte de los modelos disponibles hoy, quedando incorporadas, en muchos casos, a través de ajustes posteriores y mecanismos de corrección, y no como parte constitutiva de su arquitectura”, expusieron autoridades durante el lanzamiento.

“El desafío no fue sólo entrenar un modelo, sino construir la infraestructura para que ese entrenamiento fuera viable en nuestra región”, explicó a DPL News Rodrigo Durán, director Ejecutivo de Cenia.

Destacó tres puntos críticos:

- Curaduría de datos: “Implementar más de 20 procesos de limpieza para 300,000 millones de tokens fue una tarea titánica. No bastaba con descargar Internet; se requirió ingeniería de datos compleja para la deduplicación, anonimización y, sobre todo, el scoring de calidad mediante técnicas de LLM-as-a-judge para asegurar que el modelo no sólo hablara español, sino que entendiera contextos locales sin sesgos geográficos predominantes”.

- Optimización de cómputo: “Ante la escasez global de GPU, el desafío técnico fue la eficiencia. Implementar un scheduling preciso para un Continual Pre-training (CPT) fluido y técnicas de packing y masking para manejar la complejidad cuadrática del Transformer fue esencial para no desperdiciar ni un ciclo de procesamiento”.

- Alfabetización y gestión de alianzas: “La obtención de datos a la escala de lo que logramos requirió una coordinación institucional con 60 aliados en 15 países, de manera horizontal y descentralizada. Adicionalmente, hubo que definir mecanismos de gobernanza transparentes y confiables para el traspaso de datos desde distintos organismos. Finalmente, en muchos casos hubo que alfabetizar respecto al tipo de datos no estructurados, en texto, que se requieren para estos modelos, antes de lograr establecer alianzas firmes”.

En cuanto al uso previsto del modelo, respondió que, por su rendimiento superior en el campo de tópicos sobre América Latina y el Caribe, “los usuarios potenciales son aquellas soluciones que requieran más precisión en ese conocimiento, como educación, gobierno y atención al cliente. (…) Estamos trabajando en el desarrollo de casos de uso con aliados locales y también en conversación con empresas tecnológicas para contar durante el 2026 con un aplicativo web abierto a la ciudadanía”.

El modelo Latam.GPT 1.0 se abrirá el 28 de febrero, mientras que una versión más específica (latam.gpt 1.1) se liberará el 17 de marzo. Durán aclaró que “estos modelos serán abiertos y gratuitos para descarga y uso de cualquier persona en el mundo”.

¿Cómo se asegura la continuidad de la iniciativa? “Se desarrolló con recursos gestionados por Cenia a partir de su actividad privada, sumado a los créditos de Nube de AWS y el Data Observatory, más el aporte de profesionales, académicos y otros perfiles. En ese sentido, el apoyo gubernamental no es habilitante de la continuidad del proyecto, pero nos encantaría seguir contando con el respaldo institucional que hemos tenido hasta la fecha, que ha facilitado conversaciones con diversos agentes públicos en la región”.

Además de los aliados mencionados, Cenia está próximo a firmar un memorando de entendimiento con Microsoft para “desarrollar una versión multimodal”, y avanza con acuerdos con Google.org para robustecer el ecosistema, y con AMD, que gestiona el acceso a capacidades de cómputo para el desarrollo de versiones más livianas.

Consultado por este medio sobre las particularidades del proyecto, Hiram Monroy, líder del segmento comercial de AMD, destacó la ventaja lingüística del modelo al señalar que “los LLMs globales se entrenan en español neutro o castellano europeo. Los modelos globales genéricos no manejan tantos modismos regionales, lo que puede ofrecer ventajas en términos legales, fiscales y financieros locales. También pueden manejar lenguas indígenas regionales y así ayudar a reducir la brecha de la IA”.

La creación de modelos regionales trae consigo ventajas prácticas, no sólo técnicas, porque “permiten cumplir con los requisitos de soberanía de datos de cada país u organización”.

Monroy enfatizó que “la estrategia IA de AMD —incluye el rack de IA escalable Helios— está construida explícitamente sobre estándares abiertos en lugar de tecnologías propietarias. Esto contempla procesadores, aceleradores, interconexiones entre dispositivos y software abierto como ROCm, que en conjunto reducen significativamente los costos de desarrollo e implementación, además de acelerar el desarrollo del ecosistema a través de las aportaciones de sus distintos actores”. La compañía “enfatiza el balance entre el mayor desempeño al mejor precio, lo que es de vital importancia no sólo para hyperscalers, sino también para empresas y organizaciones que buscan flexibilidad de proveedores y mayor certeza en el control de costos a largo plazo”.

El ejecutivo también resaltó la posición de Chile en la región, al destacar que el país lidera el Índice Latinoamericano de Inteligencia Artificial.

Soberanía digital

En conclusión, Latam‑GPT no es solamente un avance técnico: cristaliza la voluntad colectiva y representa un punto de inflexión simbólico y práctico en la ambición de América Latina por convertirse en autora de su propio rumbo digital (y participante activo en la conversación global del futuro). También parece claro que es el primer paso de una larga carrera con obstáculos prácticos y técnicos que deberán superarse para traducir buenas intenciones en capacidad regional a prueba de futuro.