Nvidia presenta actualización de Rubin y nueva plataforma para coches autónomos en CES 2026

Durante su presentación principal en el CES 2026 celebrado en Las Vegas, Jensen Huang, CEO de Nvidia, hizo el anuncio de importantes avances en dos frentes estratégicos: presentó una actualización de su próxima arquitectura Vera Rubin –ya en producción– y realizó la introducción de Alpamayo, una nueva plataforma para acelerar el desarrollo de vehículos autónomos.

Respecto a Vera Rubin, su esperada nueva arquitectura para GPUs, Huang aseguró que ya se encuentra en plena producción, y que permitirá hacer frente al reto de la creciente demanda de cómputo para aplicaciones de Inteligencia Artificial (IA). Según el directivo, esta generación incluye la introducción de seis nuevos chips, que fueron requeridos para hacer frente a las demandas de cómputo, en medio de una desaceleración de la Ley de Moore (que pronosticaba que el número de transistores en un microprocesador se duplicaba cada dos años).

Esta nueva generación logra incrementar el número de transistores en 1.6 veces, pero entrega el triple de rendimiento frente a la generación anterior de Blackwell.

Entre las características más destacadas de Vera Rubin se encuentra su capacidad para manejar configuraciones de hasta 144 GPUs, cada una con 16 TB de memoria de contexto, y un nuevo sistema de encriptación que garantiza la seguridad de los datos procesados. La arquitectura promete reducir en un 75% el número de GPUs necesarias para el entrenamiento de modelos, mientras multiplica por 10 la generación de tokens y reduce su costo en la misma proporción.

Las GPUs Rubin entregan hasta 50 petaflops de rendimiento para inferencia, 35 petaflops para entrenamiento, hasta 22 Terabits por segundo (Tbps) de ancho de banda en memoria HBM4, y un ancho de banda de hasta 3.6 Tbps mediante NVLink.

Esta nueva arquitectura viene acompañada de los nuevos adaptadores de red ConnectX-9 sobre la plataforma Ethernet Spectrum X, recién introducida por Nvidia para acelerar la comunicación entre componentes y servidores en Centros de Datos construidos para IA. Según Huang, esta plataforma ya ha convertido a Nvidia en la compañía de redes (networking) más grande del mundo.

También presentó el almacenamiento nativo de IA con Nvidia Inference Context Memory Storage Platform, un nivel de caché KV nativo de IA que aumenta la inferencia de contexto largo con 5 veces más tokens por segundo, 5 veces mejor rendimiento por dólar y 5 veces mejor eficiencia energética.

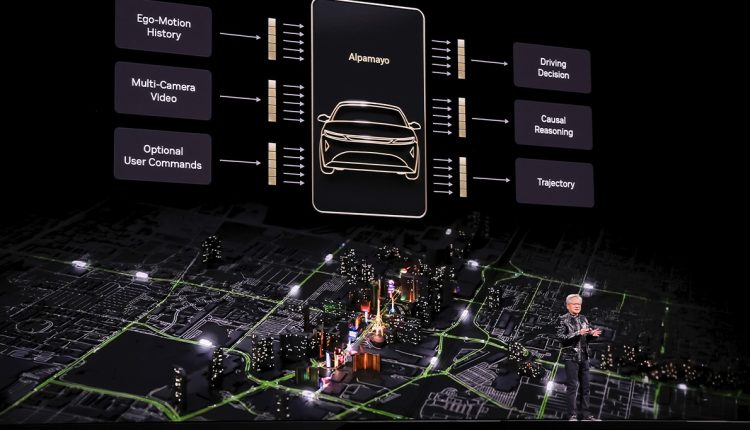

En cuanto a la incursión de la compañía en el sector automotriz, Nvidia presentó Alpamayo R1, como la primera plataforma abierta de modelos de razonamiento VLA (Vehicle Learning Architecture) para vehículos autónomos. Esta tecnología, desarrollada en colaboración con Mercedes-Benz, permite a los vehículos razonar sobre las decisiones de conducción en tiempo real, basándose en datos sintéticos generados por el sistema Cosmos.

La clave de Alpamayo es su capacidad para descomponer escenarios complejos en componentes más simples y manejables, permitiendo que el vehículo tome decisiones informadas incluso en situaciones que nunca ha encontrado antes o para los cuales no fue entrenado, explicó Huang en su presentación. Sería imposible entrenar un modelo con cada escenario posible en cada camino de cada país del mundo, por lo que el modelo debe estar preparado para razonar frente a nuevos escenarios.

El desarrollo de esta plataforma se enmarca dentro de los esfuerzos de la compañía en el desarrollo de la “IA física“, un concepto que habilitaría la actuación de robots en el mundo físico mediante la combinación del aprendizaje de las leyes físicas con la capacidad de aprender de datos limitados. Este sistema requiere tres tipos de computación: una para entrenar modelos, otra para inferencia en el borde, y una tercera diseñada específicamente para simulación.

Huang habló también sobre el desarrollo del mercado de IA, en el que Nvidia se ha convertido en el principal proveedor de los componentes de cómputo requeridos para su procesamiento. Consideró que actualmente se registra la combinación de dos cambios de plataforma simultáneos: aplicaciones que son construidas sobre IA –con entendimiento del contexto–, y aplicaciones que son desarrolladas y desplegadas en GPUs.

Aunque esta vez no se refirió específicamente a la especulación sobre la existencia de una posible burbuja –la cual ha descartado que exista–, sí atendió la pregunta sobre el flujo del dinero en las masivas inversiones de IA. Al respecto, indicó que existe un proceso de modernización por 10 billones de dólares de infraestructura de cómputo, además de miles de millones de dólares en fondos de capital de riesgo que financian procesos de investigación y desarrollo de IA.

Sobre el futuro de la IA, destacó el papel de los modelos abiertos, los cuales consideró cruciales para democratizar las capacidades de razonamiento de la IA, como lo hizo el modelo chino DeepSeek R1. También apuntó a la aparición de más aplicaciones que utilizan multimodelos, y modelos multimodales para resolver de forma más eficiente los problemas para los que fueron entrenados.

En ese sentido, destacó sus colaboraciones estratégicas con empresas como Palantir para procesamiento de datos, ServiceNow para atención al cliente, y Snowflake para datos en la Nube, evidenciando la expansión de su ecosistema de IA.