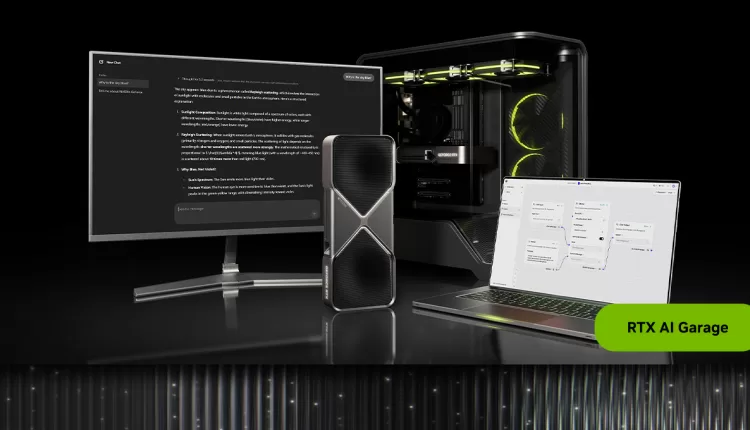

Nvidia anunció una nueva colaboración con OpenAI, la cual permitirá ejecutar la nueva familia de modelos abiertos gpt-oss de la compañía de Inteligencia Artificial (IA) en PCs y estaciones de trabajo que cuenten con las tarjetas gráficas (GPUs) de la serie RTX.

Con esta colaboración, OpenAI se suma a otras compañías que han desarrollado modelos para su funcionamiento fuera de la Nube, y que se puedan ejecutar en la infraestructura propia de las empresas, ya sean servidores o estaciones de trabajo. Se espera que esta alternativa ayude a factores como la reducción de la latencia, un mejor control de los costos, o incluso una mayor seguridad. A mediados de año, Dell anunció que sus servidores PowerEdge podrían ejecutar de forma local los modelos Gemini de Google.

Para poder ejecutar los modelos de IA en las tarjetas, OpenAI contará con dos modelos:

- gpt-oss-20b, que está optimizado para funcionar al máximo rendimiento en PCs con IA equipados con NVIDIA RTX y al menos 16 GB de VRAM, ofreciendo hasta 250 tokens por segundo en una GPU RTX 5090.

- gpt-oss-120b, de mayor tamaño, está diseñado para estaciones de trabajo profesionales aceleradas con GPUs NVIDIA RTX PRO.

Según Nvidia, estos modelos fueron entrenados en GPUs NVIDIA H100, siendo los primeros modelos que admiten precisión MXFP4 en tarjetas RTX, una técnica que mejora la calidad y precisión del modelo sin costo adicional de rendimiento en comparación con métodos anteriores. Ambos modelos admiten hasta 131,072 tokens de contexto, uno de los más largos disponibles para inferencia local.

Asimismo, están construidos sobre una arquitectura flexible de mixture-of-experts (MoE), e incluyen capacidades de cadena de razonamiento (chain-of-thought), así como soporte para seguir instrucciones y usar herramientas.

“OpenAI le mostró al mundo lo que se podía construir sobre la IA de Nvidia y ahora están impulsando la innovación en el software de código abierto”, dijo Jensen Huang, fundador y CEO de Nvidia.

Como parte de la colaboración, Nvidia anunció también nuevas herramientas para facilitar su adopción. Esto incluye Ollama, una aplicación que permite probar estos modelos de forma nativa; Llama.cpp, un repositorio en GitHub con aportes recientes como el uso de CUDA Graphs para reducir la sobrecarga; y Microsoft AI Foundry, actualmente en vista previa pública, para ejecutar los modelos con el comando Foundry model run gpt-oss-20b en una terminal.