Las Vegas, Nevada. Matt Garman, CEO de Amazon Web Services (AWS), anunció importantes avances en la infraestructura de Inteligencia Artificial (IA), con nuevas herramientas para desarrollar, gestionar y actualizar Agentes, de los que la compañía espera mil millones en funcionamiento hacia los próximos años para impulsar la productividad de las empresas.

“Cuando hablo con los clientes, muchos de ustedes no han recibido los retornos que empaten con las promesas de la IA. El verdadero valor de la IA no ha sido desbloqueado todavía”, reconoció el directivo al iniciar su presentación.

“Pero mucho de eso está cambiando, los asistentes comienzan a dar espacio a los Agentes que pueden realizar tareas y automatizar. Esto ha comenzado a generar retornos materiales de las inversiones de IA. La llegada de Agentes de IA nos ha traído a un punto de inflexión en la trayectoria de la IA, de una maravilla técnica a algo que entrega valor real”, agregó.

En ese sentido, este año el foco de AWS se volcó completamente a los Agentes, para lo que ajustó y amplió su portafolio con soluciones que proveen del cómputo necesario para su entrenamiento y desarrollo, así como disponibilidad de Agentes preentrenados en funcionalidades concretas como seguridad y código.

Garman enfatizó la visión de AWS de un futuro con miles de millones de Agentes de IA operando en las empresas. La compañía se centra en facilitar el desarrollo de Agentes, garantizando al mismo tiempo la seguridad, el cumplimiento normativo y la excelencia operativa mediante nuevas ofertas como AWS Security Agent y DevOps Agents.

Más infraestructura para IA

En medio de la carrera por el despliegue de infraestructura para dar soporte al cómputo demandado por la IA, el directivo aseguró que la compañía se ha preparado con más de 9 millones de kilómetros de cable de fibra óptica y 3.8 GW de capacidad añadidos en los últimos 12 meses. Dentro de esta estrategia destacan también los procesadores Graviton desarrollados por la propia compañía, que ya representan más de la capacidad de cómputo de su infraestructura.

En este segmento, AWS anunció la disponibilidad de nuevas instancias P6 con las GPU GB200 y GB300 más recientes de Nvidia, además del lanzamiento de instancias P6e con GPUs B200 Y B300, como parte de los esfuerzos de la compañía por ofrecer opciones a los clientes. Aseguró que la compañía de Nube es la más estable para la operación de clústers de GPUs en la industria.

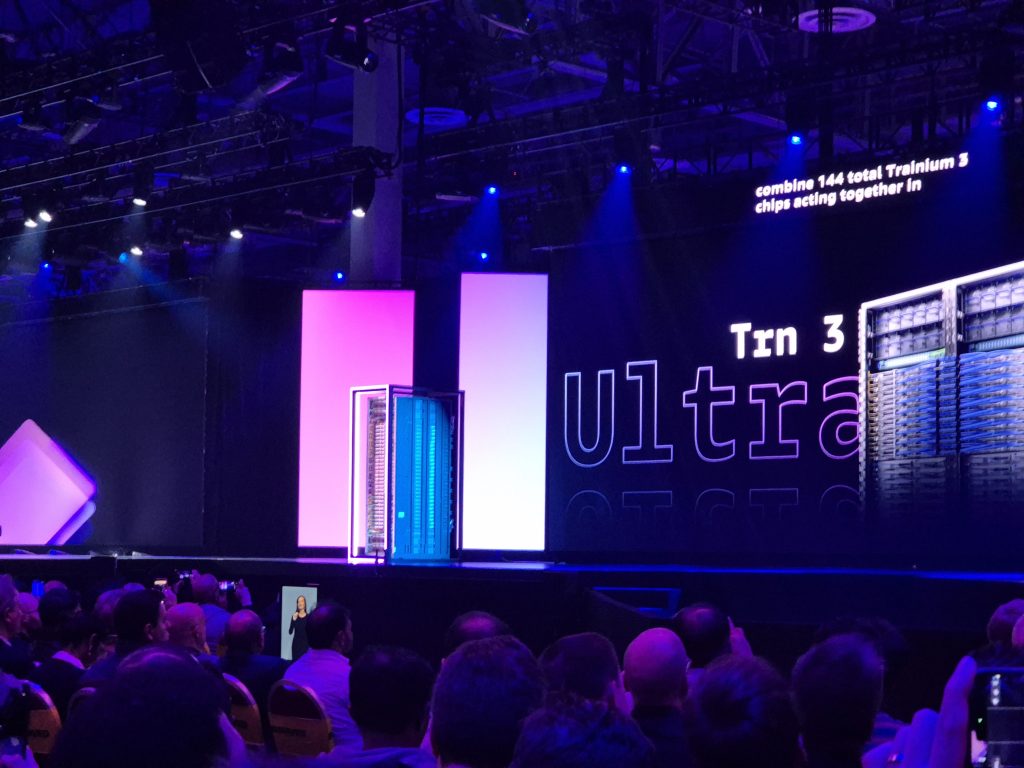

Adicionalmente, se presentó la disponibilidad de Trainium 3, el chip de IA personalizado de AWS que promete un 40% más de eficiencia energética y 4.4 veces más potencia de procesamiento. Garman ofreció también una vista previa de Trainium 4, con un gran salto de hasta seis veces de rendimiento, doble capacidad de memoria, doble eficiencia energética y hasta cuatro veces más ancho de banda.

Los chips Trainium 3, fabricados bajo un nodo de 3 nm, están disponibles en instancias Amazon EC2 Trn3 UltraServers, que ofrecen 4.4 veces más cómputo, 3.9 veces más ancho de banda de memoria y 5 veces más tokens por megawatt.

La compañía ha ampliado su colaboración con empresas de IA como OpenAI y Anthropic. En el caso de Anthropic, la asociación incluye Project Rainier, que implica la implementación de más de 500,000 chips Trainium en múltiples Centros de Datos conectados mediante AWS EFA (Elastic Fabric Adapter), con la meta de incrementar el número de chips hasta 1 millón antes del cierre del año.

Por otro lado, AWS se unió también a la competencia de las llamadas fábricas de IA, conocidas como AWS AI Factories, las cuales facilitarán el acceso a infraestructura dedicada proveída por la compañía, que se instalará en Centros de Datos propios de los clientes, con acceso a los componentes más recientes de Nvidia y todos los modelos disponibles en SageMaker y Bedrock.

Esta infraestructura permitiría atender casos de uso de IA soberana y estaría enfocado a entidades altamente reguladas como sector público y financiero, por lo que cuenta con características de cumplimiento normativo y regulación.

Software pensado para optimizar uso de IA

Garman presentó también la evolución de la plataforma de desarrollo de AWS para IA. Destacó que Bedrock ha procesado más de un billón de tokens para más de 50 clientes grandes. Las nuevas incorporaciones incluyen la integración de cuatro nuevos modelos, entre los que se encuentran Gemma de Google y Nemotron de Nvidia.

Con Mistral, compañía francesa de modelos IA de frontera, se anunció la disponibilidad de los modelos Mistral Large 3, que ofrece el doble de capacidad de contexto y más de 5 veces el número de parámetros; además de Mistral 3, con una mayor flexibilidad para atender casos de uso como el Edge.

Por otro lado, luego de la presentación de hace un año de sus modelos propios conocidos como Nova, Garman anunció también una actualización importante a este grupo de modelos. AWS introdujo la nueva iteración de sus modelos Nova 2, pensados para entregar el mejor rendimiento a un menor costo, y ahora la opción Lite optimizada para tareas como instruction calling, extracción de información de documentos y generación de código. Garman espera que Lite se convierta en uno de los más populares entre diversas industrias.

Esta nueva generación de modelos de Amazon incluye Nova Sonic, con capacidades conversacionales mejoradas; así como Nova 2 Omni para razonamiento multimodal que puede recibir información (input) en texto, imagen o video, y ofrece respuestas (output) en texto e imagen.

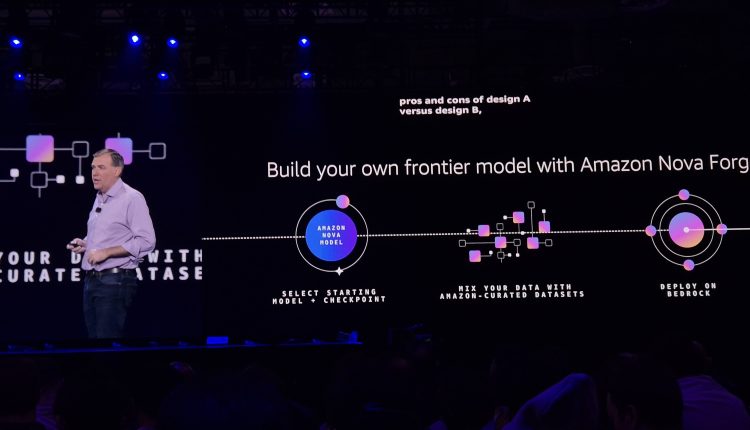

Uno de los anuncios más relevantes de la conferencia de este año se centró en Nova Forge, una nueva solución de AWS destinada para el entrenamiento de modelos personalizados con base en los datos de las propias empresas. El propósito de Forge sería acelerar el entrenamiento de modelos, sin requerir grandes inversiones en cómputo.

“La habilidad de la IA para entender los datos de tu compañía es lo que realmente empieza a entregar gran valor a tu empresa y tus clientes. Tus datos son únicos, es lo que te diferencia de la competencia. Conforme los modelos tengan más conocimiento específico sobre tus datos y procesos, pueden hacer mucho más”, reiteró Garman.

En ese sentido, entre las principales funcionalidades de Forge se encuentran acceso a modelos fundacionales, la habilidad de combinar datos propietarios con datos preentrenados por Amazon y la creación de modelos personalizados que pueden entender información específica sin perder el conocimiento fundacional.

IA Agéntica

Consolidándose como una nueva etapa en la evolución de la Inteligencia Artificial, con nuevas capacidades de automatización y delegación de tareas, los Agentes son el nuevo foco de la industria para entregar las promesas de productividad esperadas por todas las industrias.

Para atender los desafíos actuales en su implementación y desarrollo, AWS presentó la actualización de AgentCore, la cual ya ha sido descargada más de 2 millones de veces, y que ahora cuenta con funcionalidades como políticas para establecer barreras de seguridad (guardrails), la capacidad de realizar evaluaciones para asegurarse que los Agentes producen resultados de la calidad esperada, y características mejoradas de seguridad y observabilidad.

Por ejemplo, esta plataforma ahora cuenta con Policy Agentcore que permite establecer políticas claras de funcionamiento para los Agentes mediante el uso de lenguaje natural y Agentcore Evaluations, para inspeccionar la calidad de los resultados con 13 evaluaciones preestablecidas.

Por otro lado, para acelerar las tareas de programación de los desarrolladores, AWS presentó Kiro como un nuevo Agente que atendería múltiples tareas, desde tareas básicas de programación hasta atender de forma autónoma complejos flujos de trabajo. Según Garman, el Agente tiene la capacidad de recibir un objetivo y determinar de forma autónoma la mejor manera de conseguirlo, lo que reduce la intervención humana.

Amazon ya ha comenzado a implementar Kiro para sus propias necesidades de programación. En un caso de uso al interior de la compañía, el directivo aseguró que un proyecto que habría tomado el trabajo de 30 desarrolladores a lo largo de 18 meses, logró completarse con sólo 6 desarrolladores en un periodo de poco más de 70 días.

Como parte de los esfuerzos de AWS por atraer y fortalecer el ecosistema de startups, la compañía ofrece un año de acceso gratuito a Kiro, con 100 asientos disponibles.

“Nuestra motivación es brindar a los desarrolladores la capacidad de inventar y crear todo lo que imaginen”, afirmó Garman. “Con estas nuevas capacidades, permitimos que cualquier organización aproveche el poder de los agentes de IA, manteniendo el control, la seguridad y la eficiencia”.

Otros Agentes preentrenados que fueron presentados por AWS son Security Agent, enfocado en crear aplicaciones seguras de forma proactiva, y DevOps Agent, especializado en atender y resolver incidentes.