Nvidia apresenta atualização Rubin e uma nova plataforma para carros autônomos na CES 2026

Leer en español

Durante seu discurso de abertura na CES 2026 em Las Vegas, o CEO da Nvidia, Jensen Huang, anunciou avanços significativos em duas frentes estratégicas: apresentou uma atualização para a futura arquitetura Vera Rubin – já em produção – e lançou a Alpamayo, uma nova plataforma para acelerar o desenvolvimento de veículos autônomos.

Em relação à Vera Rubin, a tão aguardada nova arquitetura de GPU , Huang confirmou que ela já está em plena produção e permitirá que a empresa atenda ao desafio da crescente demanda por poder computacional em aplicações de Inteligência Artificial (IA). Segundo o executivo, esta geração inclui a introdução de seis novos chips, necessários para suprir as demandas computacionais em meio à desaceleração da Lei de Moore (que previa que o número de transistores em um microprocessador dobraria a cada dois anos).

Esta nova geração consegue aumentar o número de transistores em 1,6 vezes, mas oferece um desempenho três vezes superior em comparação com a geração anterior da Blackwell.

Entre as características mais notáveis da Vera Rubin está sua capacidade de lidar com configurações de até 144 GPUs, cada uma com 16 TB de memória de contexto, e um novo sistema de criptografia que garante a segurança dos dados processados. A arquitetura promete reduzir em 75% o número de GPUs necessárias para o treinamento de modelos , ao mesmo tempo que aumenta em dez vezes a geração de tokens e reduz seu custo na mesma proporção.

As GPUs Rubin oferecem até 50 petaflops de desempenho em inferência, 35 petaflops em desempenho de treinamento, até 22 terabits por segundo (Tbps) de largura de banda na memória HBM4 e até 3,6 Tbps de largura de banda via NVLink.

Essa nova arquitetura é acompanhada pelos novos adaptadores de rede ConnectX-9 na plataforma Ethernet Spectrum X , recentemente lançada pela Nvidia para acelerar a comunicação entre componentes e servidores em data centers com inteligência artificial. Segundo Huang, essa plataforma já tornou a Nvidia a maior empresa de redes do mundo .

A empresa também introduziu o armazenamento nativo de IA com a Plataforma de Armazenamento de Memória de Contexto de Inferência da Nvidia, um nível de cache KV nativo de IA que impulsiona a inferência de contexto longo com 5 vezes mais tokens por segundo, 5 vezes melhor desempenho por dólar e 5 vezes melhor eficiência energética.

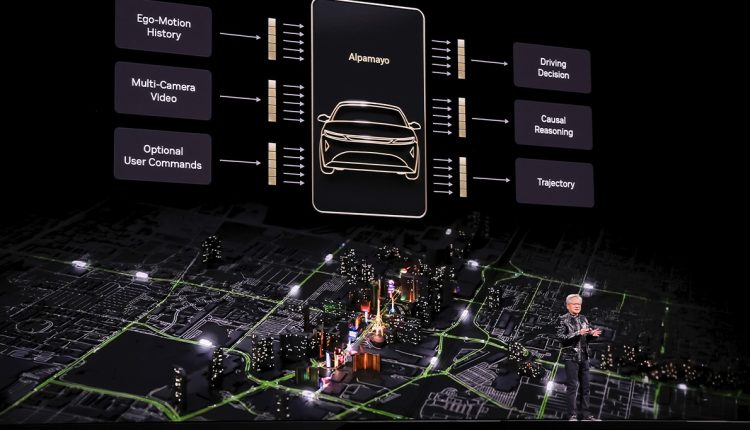

Em relação à entrada da empresa no setor automotivo, a Nvidia apresentou o Alpamayo R1 , a primeira plataforma aberta para modelos de raciocínio da Arquitetura de Aprendizagem de Veículos (VLA) para veículos autônomos . Essa tecnologia, desenvolvida em colaboração com a Mercedes-Benz , permite que os veículos raciocinem sobre decisões de direção em tempo real, com base em dados sintéticos gerados pelo sistema Cosmos.

A chave do Alpamayo é sua capacidade de decompor cenários complexos em componentes mais simples e gerenciáveis, permitindo que o veículo tome decisões informadas mesmo em situações nunca antes encontradas ou para as quais não foi treinado, explicou Huang em sua apresentação. Seria impossível treinar um modelo para todos os cenários possíveis em todas as estradas de todos os países do mundo, portanto, o modelo deve estar preparado para raciocinar diante de cenários inéditos.

O desenvolvimento desta plataforma faz parte dos esforços da empresa para desenvolver ” IA física “, um conceito que permitiria aos robôs atuarem no mundo físico, combinando o aprendizado das leis da física com a capacidade de aprender a partir de dados limitados. Este sistema requer três tipos de computação: um para treinamento de modelos , outro para inferência na borda e um terceiro projetado especificamente para simulação .

Huang também discutiu o desenvolvimento do mercado de IA, no qual a Nvidia se tornou a principal fornecedora dos componentes de computação necessários para seu processamento. Ele observou que atualmente estamos testemunhando uma combinação de duas mudanças simultâneas de plataforma: aplicações construídas em IA — com compreensão de contexto — e aplicações desenvolvidas e implementadas em GPUs.

Embora desta vez não tenha abordado especificamente a especulação sobre uma possível bolha — que ele já descartou —, ele respondeu à pergunta sobre o fluxo de dinheiro nos investimentos maciços em IA. A esse respeito, indicou que há um processo de modernização da infraestrutura de computação no valor de US$ 10 trilhões em andamento , além de bilhões de dólares em financiamento de capital de risco para pesquisa e desenvolvimento em IA.

Em relação ao futuro da IA, ele destacou o papel dos modelos abertos , que considerou cruciais para democratizar as capacidades de raciocínio da IA, como demonstrado pelo modelo chinês DeepSeek R1. Ele também apontou para o surgimento de mais aplicações que utilizam múltiplos modelos e modelos multimodais para resolver com mais eficiência os problemas para os quais foram treinados.

Nesse sentido, ele destacou as colaborações estratégicas com empresas como a Palantir para processamento de dados, a ServiceNow para atendimento ao cliente e a Snowflake para dados em nuvem, demonstrando a expansão de seu ecossistema de IA.