AWS actualiza chips para inferencia y entrenamiento de IA, y abre la puerta para romper dominio de Nvidia

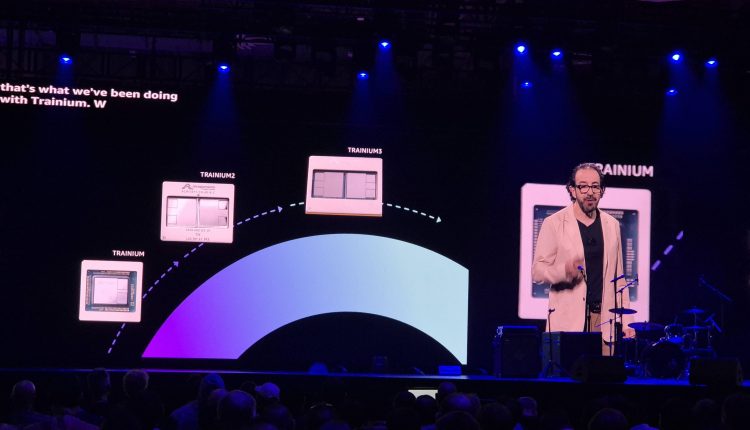

Las Vegas, Nevada. Amazon Web Services (AWS) anunció la nueva generación de sus chips propietarios, Graviton5 y Trainium3, para mejorar la eficiencia de cargas de trabajo en la Nube, y especialmente las más nuevas relacionadas con Inteligencia Artificial (IA). Además, la compañía presentó también una alternativa que permitiría a empresas mover sus aplicaciones de IA fuera de la infraestructura de Nvidia.

Durante la más reciente edición de re:Invent, Peter Desantis, vicepresidente sénior de productos de cómputo de servicios públicos de AWS, reiteró el compromiso de la compañía con los atributos centrales de la Nube: seguridad, disponibilidad, rendimiento, elasticidad, rentabilidad y agilidad, como la base para la innovación alrededor de la IA.

Dentro de estos atributos se encuentra la estrategia de chips propios de AWS, enfocados principalmente en entregar la mayor eficiencia en costo en diversas cargas de trabajo, además de resolver problemas particulares para liberar el rendimiento de la Nube. Por ejemplo, Nitro se introdujo para resolver problemas de jitter en sistemas virtualizados.

David Brown, vicepresidente de servicios de computación y ML de AWS, aseguró que la introducción de estos componentes “demostró que si se podía controlar el silicio, el hardware y la arquitectura del sistema, se podían obtener mejoras en el rendimiento y la eficiencia que simplemente no estaban disponibles con el hardware convencional”.

Como parte de la estrategia de la compañía por ofrecer más opciones a sus clientes, Brown presentó Graviton5, un CPU destinado a entregar la mayor eficiencia al menor costo en cargas de trabajo específicas de Nube. Algunos de los primeros clientes incluyen Adobe, que ha logrado cortar sus emisiones en más de 50%, así como la Fórmula 1, que ejecuta simulaciones 40% más rápido.

También lee: AWS prepara a empresas para la operación de miles de millones de Agentes

Además, este nuevo chip personalizado viene acompañado de mejoras en refrigeración, basada en una solución que elimina capas entre socket y chip, logrando reducir la energía requerida para el control de la temperatura en un 33%.

Otra de las mejoras es el incremento de la caché L3 –memoria conectada directamente al chip– en 5 veces respecto a iteraciones anteriores (2.6 veces más por núcleo), lo que reduce significativamente los viajes de memoria.

Equipado con 92 cores, Graviton5 estará actualmente disponible en instancias M9g en EC2, que prometen hasta 30% de mayor rendimiento para las bases de datos, 35% más rápidas para las aplicaciones Web y 35% más rápidas para las cargas de trabajo de Machine Learning en comparación con la generación anterior.

Según DeSantis, Airbnb ya logró un 25% mejor rendimiento con el cómputo de Graviton5, y SAP logró una mejora de hasta 60%.

Dentro de los socios que ampliarán el uso de este nuevo CPU, se encuentra Apple, que anunció la disponibilidad de Swift, su interfaz de programación propietaria, en instancias con Graviton. La propia compañía afirma que el uso de este componente le ha permitido incrementar el rendimiento en sus cargas de trabajo en un 40%, mientras se redujeron los costos en 30%.

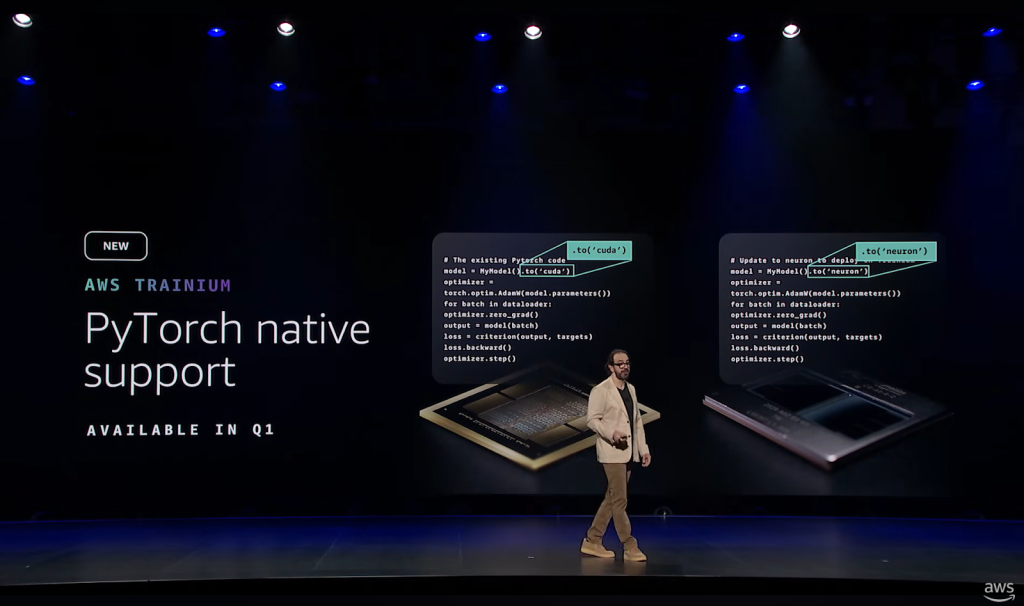

Por otro lado, una de las principales características presentadas por DeSantis para acelerar la adopción de Trainium en cargas de trabajo de inferencia, fue incluir soporte nativo para PyTorch, una biblioteca para Machine Learning (ML) de código abierto desarrollado por Meta, a partir del primer trimestre del próximo año.

Según DeSantis, ahora Trainium podrá ejecutar código desarrollado en CUDA de Nvidia con sólo cambiar una línea de código para ejecutarse en Neuron, la pila de desarrollador de AWS para ejecutar cargas de trabajo de Aprendizaje Profundo e IA Generativa. El directivo espera que esto atraiga el interés de investigadores y estudiantes por usar Trainium sin tener que desarrollar un nuevo código desde cero.

Más allá de la eficiencia de las GPUs fabricadas por Nvidia para ejecutar cargas de trabajo de IA, expertos e industria apuntan que la dominancia de la compañía se debe en buena parte al posicionamiento de CUDA. Siendo una de las primeras interfaces para entrenar Deep Learning, la plataforma afianzó su posicionamiento en el mercado, lo que reduce el interés de empresas y desarrolladores por migrar a nuevas alternativas.

Búsqueda por vectores

DeSantis presentó múltiples funcionalidades para trabajar con la vectorización de datos, que ayuda a realizar mejores búsquedas y optimizar el funcionamiento de bases de datos. La compañía introdujo Amazon S3 Vectors como el primer almacenamiento de objetos en la Nube con soporte para mejorar la búsqueda y almacenamiento de vectores.

Esta nueva funcionalidad ya ha habilitado nuevos casos de uso, como la startup de análisis de videos Twelvelabs. La compañía presentó dos modelos basados en IA: Marengo, para optimizar la búsqueda de información en videos; y Pegasus, para realizar análisis de videos.

Asimismo, se presentó Decart, que utiliza inteligencia visual, combinando modelos grandes de lenguaje (LLM) y modelos diffusion, para crear efectos en tiempo real efectos sobre videos, por ejemplo, filtros en una red social, probarse una prenda antes de comprarla o nuevas modalidades en las grandes pantallas de eventos deportivos.

Otras novedades presentadas por De Santis incluyen una mayor flexibilidad en la nueva era de cargas basadas en IA, como AWS Lambda Managed Instances, que mantiene la flexibilidad del servicio serverless, pero con capacidad de acceder a opciones de cómputo; y funcionalidades en Bedrock, para priorizar cargas de trabajo y asegurar el trabajo en caso de incidentes.

Vogels defiende papel del desarrollador en la era de la IA

En lo que fue su última participación para un re:Invent, Werner Vogels, director de Tecnología de Amazon, defendió el papel del desarrollador en la nueva era de la IA, donde esta tecnología ahora puede realizar múltiples tareas de programación. Señaló que los desarrolladores ya se han enfrentado antes a pronósticos de desaparición o irrelevancia, pero así como las herramientas de programación han evolucionado, también lo tendrán que hacer estos profesionales.

Aseguró que la Inteligencia Artificial no hará obsoletos los trabajos de desarrollo, sino que transformará el rol del programador. Estamos en una “nueva era del Renacimiento”, donde los desarrolladores deben adoptar cinco cualidades clave: curiosidad, pensamiento sistémico, comunicación precisa, sentido de pertenencia (ownership) y polimatía para navegar y prosperar con las nuevas herramientas y desafíos de la IA.